O processo de avaliação por pares tem o objetivo de assegurar a qualidade, a precisão e a relevância dos trabalhos de pesquisa antes de serem divulgados à comunidade acadêmica. Porém, mesmo com esse processo alguns pesquisadores ainda conseguem fraudá-lo.

Fraudes em processos acadêmicos, embora condenáveis, infelizmente não são incomuns. Um exemplo emblemático envolve a utilização indevida de nomes de pesquisadores na etapa de seleção de avaliadores. Essa prática consiste em falsificar a identidade de avaliadores ou utilizar indevidamente seus nomes para subverter o rigor do processo, resultando na publicação de trabalhos que não atendem aos padrões científicos.

Relatos disto na mídia, como os apresentados na notícia 1 e notícia 2, revelam como essa prática compromete a integridade do processo. A situação é agravada quando trabalhos fraudulentos geram desdobramentos na literatura, propagando dados imprecisos e comprometendo avanços em diversas áreas.

Este caso de fraude resultou na retratação de mais de 20 artigos pela editora Elsevier (notícia 3). Isso gerou repercussão e debates no meio acadêmico levantando questionamentos sobre as fragilidades do sistema de avaliação. A descoberta de avaliadores falsos mina a confiança em todo o processo editorial e reforça a necessidade de protocolos mais rigorosos. Um exemplo de retratação de um artigo suspeito de não respeitar o processo pode ser encontrado aqui. Em sua defesa, o acusado publicou uma carta aberta, contestando as acusações e apontando possíveis falhas no processo de investigação.

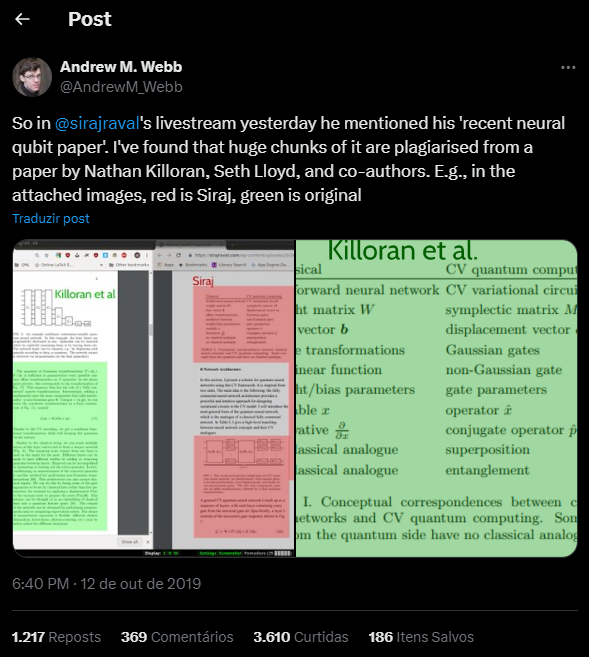

Fraudes, no entanto, não se restringem a etapa de avaliação por pares, podem acontecer antes da submissão. Em 2019, o influencer youtuber Siraj Raval foi acusado no twitter de plagiar trechos substanciais em um artigo de sua autoria: "The neural Qubit", conforme detalhado em notícia 4. A repercussão negativa causou danos à reputação do Raval. Um exemplo foi a remoção de sua entrevista com o pesquisador em inteligência artificial Lex Fridman.

Postagem no twitter comparando as semelhanças entre o artigo “The neural Qubit” com outro já publicado

Casos como o de Raval evidenciam como o uso inadequado de ferramentas tecnológicas pode levar a práticas antiéticas, especialmente quando a responsabilidade pela geração de conteúdo é negligenciada. No vídeo publicado em seu canal do YouTube, Raval argumentou que utilizou uma versão inicial da ferramenta de IA generativa, o GPT-2, para a geração do texto e alegou que essa prática é hoje aceita. Ele conclui que o fato em 2019 demonstrou sua visão pioneira.

No entanto, a questão levanta discussões sobre a ética no uso de inteligência artificial, especialmente em contextos acadêmicos, onde a originalidade e a precisão são fundamentais para o avanço do conhecimento. A situação também ressalta a importância de diretrizes claras para o uso dessas ferramentas, a fim de evitar ambiguidades e preservar a integridade científica.